生成式 AI 帶來資安威脅,哪些策略可以協助企業因應資安風險?

July 20, 2023

生成式 AI 如今已被企業視為不可或缺的輔助工具,許多公司甚至表示它已經超越了員工能創造的價值。然而,雖然生成式 AI 賦予企業良好的工作效率,但也讓外部攻擊者能透過惡意使用造成企業威脅,而內部員工的使用同時也可能帶來可觀的資安風險。對此,企業該如何在生產力和安全性之間取得平衡,並輔以安全策略來為企業內部的安全把關呢?

無所不在的生成式 AI 工具

根據 ResumeBuilder.com 的數據顯示,1,000 名美國商業領袖中有 49% 的人表示公司正在使用生成式 AI (像是 ChatGPT) ,更有高達 93% 的企業表示未來將擴大聊天機器人的使用。對企業領袖而言,使用生成式 AI 能協助內部撰寫文案、招募人才、編寫程式碼,進而能夠節省大量的資金支出,因此大多數企業領導者都十分認可生成式 AI 的工作表現,也顯示生成式 AI 在企業內部逐漸成為一種無所不在的工具。

生成式 AI 可能帶來資安風險

隨著企業對生成式 AI 展現高度青睞 ,領導者很可能沈浸在其創造的正面效益而忽略隨之而來的安全威脅。事實上,生成式 AI 很可能讓大部分企業面臨顯著的資安風險。

網路攻擊者利用生成式 AI 破解密碼,進而引發企業存取安全疑慮

在企業使用生成式 AI 的同時,網路犯罪組織當然也不忘使用科技力量達成攻擊目的。而由於 AI 非常擅長模仿人類,因此駭客很可能透過濫用生成式 AI 來猜測密碼、破解驗證碼,進而入侵公司系統並部署惡意軟體。

舉例而言,CircleCI 就於今年初表示內部一位工程師因此感染了惡意軟體,進而引發後續的資安問題。這不僅顯示惡意使用生成式 AI 的現象無可避免,更表示薄弱的密碼設定特別容易受到駭客攻擊,進而使得多因素身分驗證的重要性與日俱增。

員工恣意使用生成式 AI 工具,導致企業資料外洩風險增加

AI 可以輕鬆進行資料分析並提供多方考量,這對於渴望提高生產力的員工而言是再好不過的輔助工具,因此大多數員工都認為註冊生成式 AI 是一項看似有利無害的操作。然而,由於員工使用生成式 AI 通常是為了創造更好的工作績效,因此在操作過程中很可能涉及機密敏感資訊,進而讓企業面臨資料外洩風險。

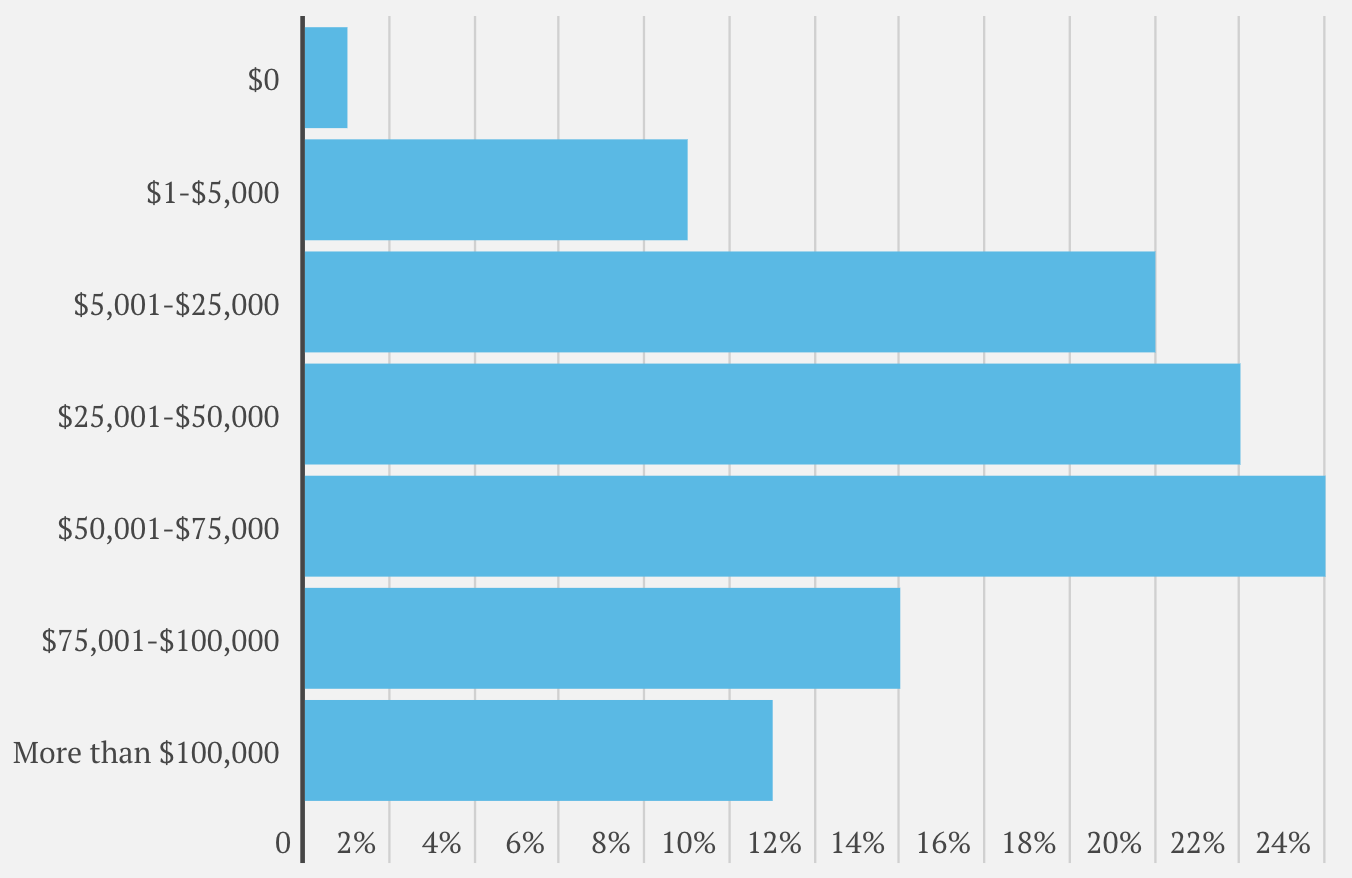

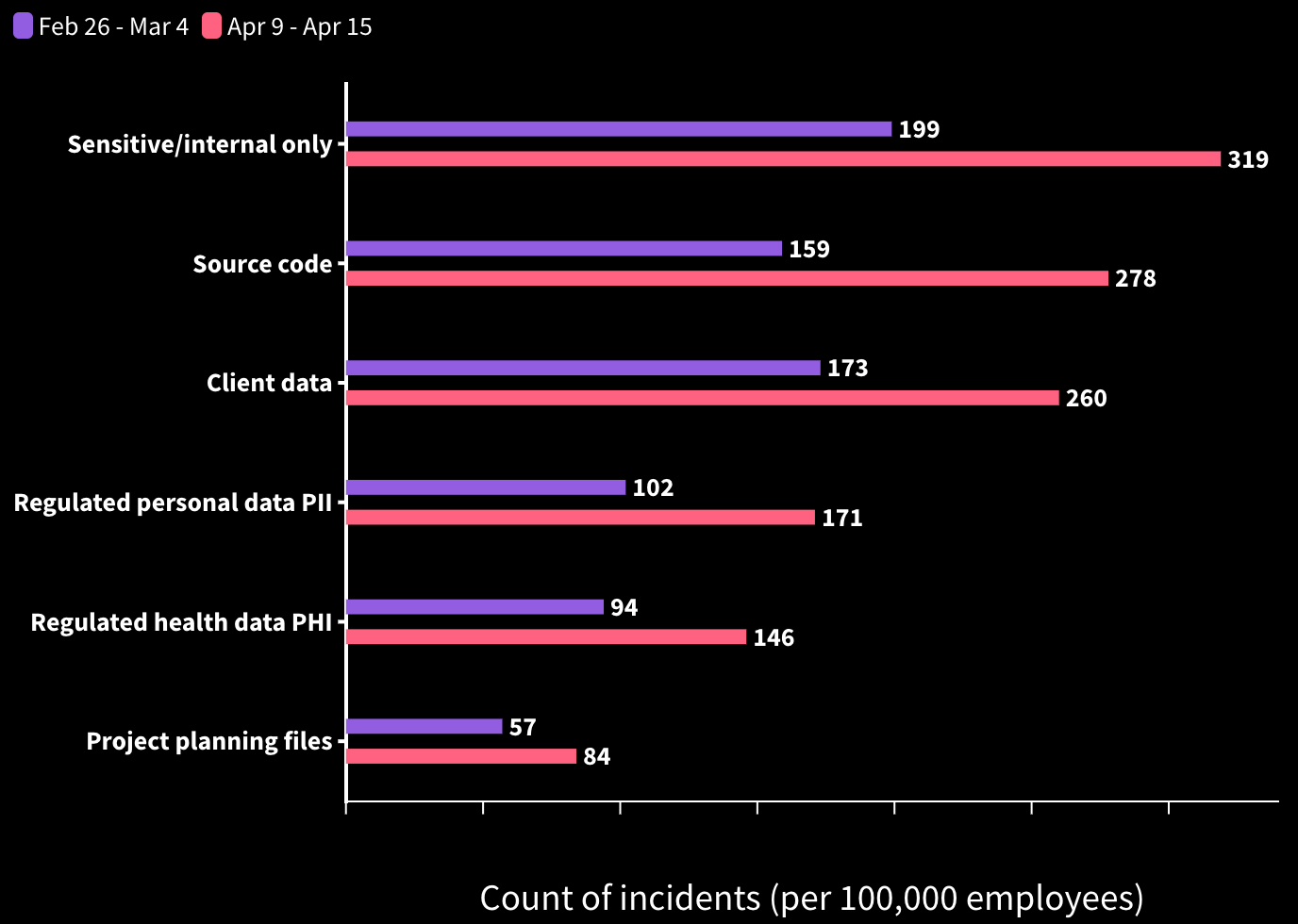

根據 cyberhaven 的報告指出,160 萬名員工中有 3.1% 的人表示他們曾將企業機敏資訊上傳至 ChatGPT,而由於內部安全人員對這些 AI 工具無法進行全面的監督和控制,導致這些機敏資料可能落入競爭對手或不明人士手中,最終讓企業的資料安全受到威脅。

企業應該實施的內部資安策略

為了有效應對生成式 AI 帶來的風險,企業必須實施強大的安全措施來抵禦外部攻擊,同時也要讓員工了解使用 AI 工具可能產生的潛在安全後果。以下提出企業可以採行的安全策略來保護其營運環境。

提高企業內部的身分驗證強度

有鑒於駭客能透過生成式 AI 掌握密碼破解能力,公司的安全團隊可以在內部實施「零信任策略」來提高身分驗證強度,透過無密碼登入和多因素驗證(MFA)等方式來達成更快速且安全地登入。整體而言,通過完善的存取控制能夠協助企業達成最佳安全實踐。(HENNGE Access Control 致力於提供優質的身分驗證服務,進而為企業的存取安全把關)

領導者應與員工達成安全共識

以生成式 AI 在企業內的高覆蓋率來看,我們幾乎可以肯定人類對 AI 工具的依賴將繼續蔓延。而員工對於提高生產力的訴求本身並非壞事,因此一味禁止他們使用生成式 AI 絕非是最理想的安全防護策略。相反的,企業領導者應該適時提出使用這些工具時的安全疑慮,以達成安全共識而不是譴責的態度來面對員工,進而讓員工提升使用 AI 工具時的安全意識。

喜歡這篇文章嗎?歡迎分享出去!